Interner KI-Assistent mit RAG: Unser Praxisbericht

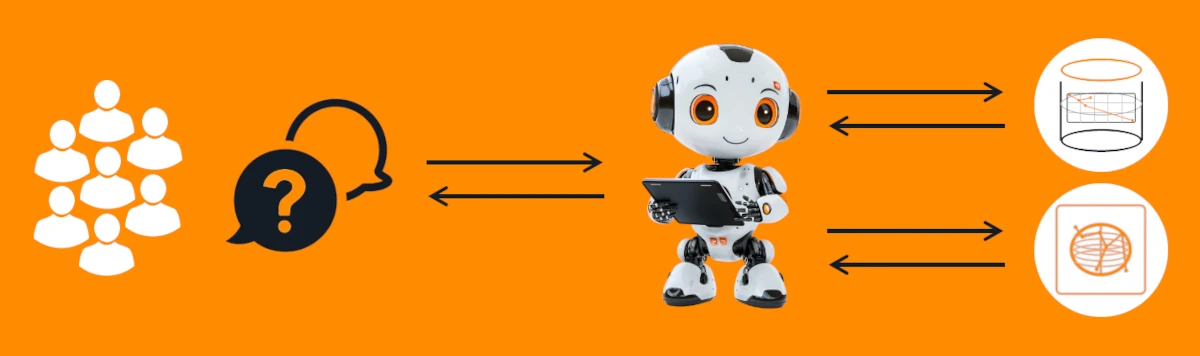

Unsere Internetagentur hat in diesem Projekt einen KI-Assistenten auf RAG-Basis für das firmeninterne Wissensmanagement entwickelt: RAG (Retrieval Augmented Generation) verknüpft ein großes KI-Sprachmodell (LLM) mit einer präzisen wie leistungsfähigen Suche in den eigenen Dokumenten. - Daraus entstehen Antworten, die nachvollziehbar auf den eigenen Unternehmensquellen basieren. In unserem Praxisprojekt haben wir einen firmeneigenen KI-Assistenten aufgebaut, der ausschließlich auf die hinterlegten Handbücher, Berichte & FAQs zugreift und darauf basierend die Mitarbeiterfragen beantwortet. - Der Zugriff auf den RAG-Chatbot erfolgt über ein geschütztes Web-Frontend. Das Wissensmanagement mit der Künstlichen Intelligenz bringt den Abteilungen klare Antworten und liefert dazu transparent die Quellenangaben. - Die Eigenentwicklung setzt mit Ausnahme des LLM ausschließlich auf frei verfügbare Open-Source-Komponenten und beugt damit bereits im Vorfeld späteren Abhängigkeiten (Vendor-Lock-in), aber auch laufenden Lizenzgebühren vor. Unsere Lösung ist DSGVO-konform und ohne Datenabfluss, modular erweiterbar und skalierbar. Der nachstehende Praxisbericht zeigt Setup, Learnings und Ergebnisse. (Weiterlesen: Interner KI-Assistent mit RAG – Praxisbericht)

Use Case: Wissenszugriff für Mitarbeitende

Unser Kunde: Ein über vier Jahrzehnte gewachsenes, mittelständisches Dienstleistungsunternehmen. Durch Generationswechsel, Expansion und die zunehmende Technisierung der Branche sind umfangreiche Prozesse, Dokumente und Richtlinien entstanden – verteilt über Handbücher, interne Laufwerke, E-Mails und Wissensinseln einzelner Mitarbeitender. Damit einhergehend ein enormer Suchaufwand, Inkonsistenzen und Know-how-Abhängigkeiten im Alltag. Im gemeinsamen Gespräch war die Zielsetzung rasch gefunden: Mitarbeiter aus den Bereichen Vertrieb, Technik und Support sollen künftig schnell, zuverlässig und selbstständig Antworten aus dem internen Wissensbestand finden können – direkt aus geprüften, unternehmensÂeigenen Quellen und mit Quellenangabe für die Möglichkeit einer persönlichen Prüfbarkeit. → Hier finden Sie weitere KI-Use Cases

Den Rahmen der Umsetzung bildet eine DSGVO-konforme Lösung in unserer Privat-Cloud, die eine Weitergabe von Inhalten an Dritte ausschließt und kein Training auf Basis von Nutzereingaben vorsieht.

Ein grundlegendes Rollen und Rechtekonzept erlaubt den IP-geregelten Zugriff auf den KI-Assistenten nach Login (2FA - zweistufige Authentifizierung möglich), ein Upload von Unternehmensdokumenten oder eine NeuinÂdexierung ist damit nur für fest definierte Rollen möglich. Technisch betreiben wir Backend und Vektordatenbank in Docker-Containern (Deployment via Docker Compose). So bleibt ein später gewünschter Transfer zwischen Private-Cloud und On-Premises bequem, sicher und reproduzierbar.

Mit einem Augenzwinkern - Die Anwendung in der Praxis

Unsere Architektur im Ãœberblick

Unser Lösungsansatz ist bewusst modular aufgebaut: Ein sicheres, vertrautes Frontend, ein leichtgewichtiges FastAPI-Backend und Qdrant als performanter Vektorstore. Alle Bausteine sind damit skalierbar und „containerfähig“ – und können somit gleichermaßen in der Private-Cloud wie On-Premises laufen. Aus Kostengründen setzen wir aktuell ein effizientes LLM (ChatGPT-mini40) ein; die Architektur bleibt jedoch modell-agnostisch, sodass sich das Sprachmodell jederzeit austauschen oder erweitern lässt. Im Ergebnis haben wir damit die Grundlage für zukunftssichere, wartungsarme Komponenten, klare Betriebskosten – und vollständige Datenkontrolle.

Keine Sorge:

Die folgende Architektur zeigen wir aus Transparenzgründen für unsere technischen Ansprechpartner in Ihrem Betrieb. Wenn Sie nur wissen wollen, dass alles zuverlässig läuft, können Sie diesen Abschnitt gerne überspringen. Hier direkt weiter zu: Kriterien & Alternativen zum Tech-Stack

Was ist ein LLM?

Ein Large Language Model ist eine Software, die Texte versteht und formuliert – ähnlich wie ein sehr guter Assistent, der Fragen beantwortet, zusammenfasst oder formuliert. Warum wichtig: Es erzeugt die Antwort – aber ohne Zusatzquellen kann es auch mal danebenliegen.Was ist RAG)

RAG (Retrieval Augmented Generation) kombiniert das Sprachmodell mit einer Suche in Ihren Dokumenten: Erst werden passende Textstellen gefunden, dann fasst das LLM sie zur Antwort zusammen. Warum wichtig: Antworten stammen nachweisbar aus Ihren Quellen (mit Zitaten/Seitenangaben).Was ist eine Vektordatenbank?

Eine Vektordatenbank (z. B. Qdrant) speichert Texte so, dass ähnliche Inhalte zueinander gefunden werden – auch wenn die Formulierung anders ist. Warum wichtig: Nutzer fragen „natürlich“, die Suche findet trotzdem die richtigen Stellen.

Das Frontend (Login, Rollen, Proxy)

Der KI-Wissens-Assistent ist in eine schlanke, ablenkungsfreie Chat-Oberfläche im Corporate Design integriert. Der Zugriff auf den Private-Cloud-Server (und damit den Login) ist IP-basiert auf freigegebene Standorte/Netze beschränkt; nur autorisierte Geräte erreichen die Anwendung.

Mitarbeitende melden sich wie gewohnt an und stellen Fragen in natürlicher Sprache. Der Assistent ist Mehrsprachig nutzbar (u. a. Deutsch und Englisch; weitere Sprachen auf Anfrage) und verweist in den Antworten transparent auf die Quellenangaben (Dokument & Seite). Alle Anfragen werden ausschließlich gegen die internen, geprüften Dokumente beantwortet; keine Weitergabe an Dritte, kein Training mit Nutzereingaben – DSGVO-konform und unter vollständiger Kontrolle des Unternehmens.

Der KI-Assistent ist an dieser Stelle modular erweiterbar und formuliert Antworten dann auf Wunsch in eigenen Worten – auf Basis der gefundenen Auszüge und in der Sprache der Frage. Optional können auch externe Quellen einbezogen werden (z. B. Wikipedia/Branchenportale) – jedoch nur nach datenschutzrechtlicher Prüfung, mit klarer Kennzeichnung und strikt getrennt von internen Dokumenten (kein Datenteilen, kein Training mit Nutzereingaben).

Im Kern:- Genereller Zugriff nur für Berechtigte

- Rollen und Rechte steuern, wer fragen, hochladen oder neu indizieren darf.

- Inhalte, Menüs und Seiten bleiben im gewohnten, bekannten Corporate Design

- Sicher angebunden: Der Chat spricht nur mit dem internen Backend und liefert keine externen Endpunkte.

FastAPI-Backend & Qdrant

Programmseitig empfängt das Backend die Fragen, durchsucht die freigegebenen Dokumente und liefert Antworten mit Quellenangabe. Qdrant fungiert als Vektordatenbank, sodass auch natürlich formulierte Fragen die richtigen Textstellen in PDFs & Co. treffen.

Für höhere Präzision kombinieren wir die Suche mit Reranking, das die relevantesten Passagen nach vorn sortiert. Die Lösung ist mehrsprachig nutzbar (z. B. Deutsch/Englisch) und damit auch für internationale Teams geeignet. Gleichzeitig bleiben die Datenflüsse unter Kontrolle: Es erfolgt keine Weitergabe an Dritte und kein Training auf Basis von Nutzereingaben.

In Summe erreichen wir damit nachvollziehbare Antworten mit Seitenangabe und Quellenverweis – das schafft Vertrauen und reduziert Rückfragen.

Ingestion & OCR (Qualitäts-Gate)

Die Bereitstellung firmeninterner Dokumente erfolgt durch berechtigte Anwender in einem gesonderten Upload-Bereich im Frontend. Die freigegebenen PDFs werden beim Import in handliche Textabschnitte zerlegt, Scans ohne Text durchlaufen OCR, um durchsuchbar werden. Duplikate, alte Versionen oder ungeeignete Dateien werden dabei herausgefiltert, so dass der Wissensbestand sauber bleibt. Neue oder geänderte Dokumente können somit planmäßig eingelesen werden.

Kriterien & Alternativen zum Tech-Stack

Die KI-/Search-Landschaft bewegt sich nach wie vor - und vermutlich auch weiterhin - rasant. Die Technologieauswahl sollte sich daher zunächst an Ãœberlegungen zum Reifegrad (Release-Stand), der Roadmap und Supportbarkeit der Komponenten zugunsten einer tragfähigen Lösung orientieren. Angesichts der schnellen Innovationszyklen priorisieren wir gerne mature Releases mit belegter Betriebsstabilität, SicherheitsÂupdates und Langzeit-Wartung als Basis für skalierbare Entscheidungen und kalkulierbare Kosten.

n8n nutzten wir in frühen Prototypen als Orchestrierung, Amazon Bedrock als mögliche LLM-Plattform. Für den produktionsnahen Einsatz haben wir uns jedoch für ein schlankes Web-Frontend + FastAPI + Qdrant entschieden. Die Vorteile aus unserer Sicht: volle Datenhoheit (DSGVO, On-Prem/Private Cloud), modulare Kontrolle über Retrieval & Reranking, modell-agnostische Anbindung (LLM austauschbar) sowie kalkulierbare Kosten ohne Plattform-Lock-in. Die Entscheidungsgründe:

Datenhoheit & DSGVO:

Private-Cloud/On-Prem möglich; keine Weitergabe, kein Training auf Eingaben.Vendor-Neutralität:

LLM frei wählbar/tauschbar; Qdrant & FastAPI sind Open-Source-basiert.Retrieval-Qualität:

Feingranulare Kontrolle (Chunking, Reranking, Synonyme/Varianten) statt „Black-Box-Pipeline“.Kostensteuerung:

Keine zusätzlichen Plattform-Aufschläge; Ressourcen planbar.Betrieb & Skalierung:

Containerfähig; klare Trennung Frontend/Backend/Vektorstore; Monitoring und Backups einfach.Integration:

Web-Login/Rollen/Berechtigungen, später SSO; Upload→OCR→Ingest als wiederverwendbare Jobs.

n8n eignet sich hervorragend für Low-Code-Automationen und zeitgesteuerte Pipelines – etwa für OCR-Läufe, Dateikonvertierungen oder Benachrichtigungen – und für schnelle Proofs of Concept. Unsere Empfehlung: n8n ergänzend einsetzen, z. B. als Ingest-Automator (Upload → OCR → Indexierung). Für das Kern-Retrieval (semantische Suche, Reranking, Antwortlogik) sollte jedoch eine eigenständige Architektur genutzt werden.

Amazon Bedrock spielt seine Stärken aus, wenn eine tiefe AWS-Integration gefragt ist – inklusive Compliance, Security und Observability – oder wenn Managed LLMs und Guardrails im großen Maßstab benötigt werden. Unsere Empfehlung: Bedrock als LLM-Backend andocken (modell-agnostisch bleiben), während Retrieval und Reranking weiterhin eigenständig betrieben werden, um Datenhoheit und Tuning-Kontrolle zu behalten.

Ein KI-Projekt ist keine klassische Softwareentwicklung

Wichtig für Entscheider: KI-Engineering ist keine Softwareentwicklung – Ansatz, Werkzeuge und Erfolgsfaktoren sind andere, aber auch die Implementierung in den laufenden Betrieb sollte anders angedacht werden. → Mehr zu Digitaler Strategie & KI

Klassische Software folgt meist einem festen Pfad: Anforderungen → Programmierung → Tests → Go-live. Ein RAG-Assistent arbeitet anders: Neben Code entscheidet vor allem die Qualität und Aufbereitung der Inhalte über das Ergebnis. Entsprechend ist der Weg stärker daten- und feedbackgetrieben – wir verbessern die Antwortqualität nicht nur durch Programmieren, sondern durch Kuratur, Strukturierung und Tuning.

- Datenqualität statt nur Code:

Volltext-PDFs funktionieren sofort; gescannte Dokumente mussten wir per OCR lesbar machen. Veraltete/duplizierte Dateien wurden kuratiert, damit der Assistent verlässliche Grundlagen hat. - Struktur schlägt Masse:

Inhalte wurden in sinnvolle Text-Chunks zerlegt (mit Overlap), damit Fragen genau dort landen, wo die Antwort steht. - Treffergenauigkeit erhöhen:

Auf die semantische Suche (Embeddings) folgt ein Reranking mit Cross-Encoder – dadurch kommen die relevantesten Passagen nach vorn. - Fragestil robust machen:

Für technische Nummern/Bezeichner haben wir Varianten-Logik ergänzt (Trennzeichen, Leerzeichen), damit auch realistische Tipp- und Schreibweisen gefunden werden. - Tuning statt Re-Write:

Wir verbessern die Ergebnisse iterativ über Parameter (Top-K, ef, Batchgrößen) – ohne das System neu zu programmieren.

Anders als bei herkömmlicher Software entsteht der Mehrwert hier nicht allein im Code, sondern im Zusammenspiel aus Datenqualität, sinnvoller Aufbereitung und gezieltem Retrieval-Tuning. Dieses Vorgehen liefert in kurzer Zeit praxisrelevante, nachvollziehbare Ergebnisse – und bleibt zugleich erweiterbar (z. B. formulierte Antworten, externe Quellen nach Prüfung).

Veränderungsmanagement & kontinuierliche Anpassung

Die Einführung von KI verändert Aufgaben, Abläufe und Gewohnheiten. Entscheidend ist ein geplantes Change-Management: Je nach Betriebsgröße sichern kurze Workshops, Sprechstunden oder begleitete Tests die Akzeptanz und mindern Unsicherheiten. Mitarbeitende brauchen Zeit zum Eingewöhnen – inklusive klarer Ansprechpersonen und einer Feedback-Schleife (z. B. zweiwöchige Review-Calls). Kommunizieren Sie sichtbare Gewinner:innen: Teams, die von monotonen Tätigkeiten entlastet werden und damit mehr Zeit für Kernaufgaben, Qualität und Kundennähe gewinnen. Planen Sie KI als kontinuierlichen Prozess: mit messbaren KPIs (z. B. Suchzeit, Erstlösungsquote, Zufriedenheit), regelmäßigen Dokumenten-Updates und kleinen Runden von Verbesserungen (Chunking, Reranking, Upload-Workflows) – so bleibt der Nutzen dauerhaft hoch.

Wie Sie dieses „Training“ in der Praxis strukturieren (Hausstil/System-Prompt, Retrieval-Tuning, Quellenlogik, Benchmarks), zeigen wir hier: KI-Assistent trainieren: Antwortqualität in RAG-Systemen gezielt verbessern.

Die KI-Roadmap: Von der Pilotlösung zur Breitenwirkung

Nach dem Go-live der ersten Fachabteilung skalieren wir schrittweise in weitere Bereiche – z. B. Vertrieb (Produkt-/Preis-/Angebotswissen, Einwände, Wartungsintervalle) und Technik (Handbücher, Ersatzteile, Störungen/Workarounds). Der KI-Rollout folgt einem klaren Muster: Use Case schärfen → Dokumente kuratieren → Qualität messen → ausrollen. Parallel erweitern wir Funktionen modular: formulierte Antworten (LLM-Zusammenfassung in der Frage-Sprache), rollenbasierter Upload mit Auto-Ingest, Mehrsprachigkeit für internationale Teams, sowie optional externe Quellen (whitelist-basiert, klar gekennzeichnet, DSGVO-geprüft). Rechte und Sichtbarkeiten lassen sich per Rollen/ACL abbilden – so sieht jede Abteilung nur die für sie freigegebenen Inhalte.

Skalierbarkeit & Betriebssicherheit

Die Architektur ist containerfähig und wächst mit: zusätzliche Rechenleistung, getrennte Collections pro Abteilung, regelmäßige Batch-Ingests (z. B. täglich) und Monitoring von Qualität und Nutzung. Wir etablieren KPIs (Suchzeit, Erstlösungsquote, Zufriedenheit) und einen zwei- bis vierwöchigen Verbesserungszyklus (Chunking/Reranking feinjustieren, Lücken schließen, neue Quellen anbinden). Optional ergänzen wir SSO (z. B. Azure AD), Audit-Logs, Deduplizierung und Retention-Policies. Ergebnis: ein wachsender Wissens-Copilot, der pro Team spürbaren Nutzen stiftet – kontrolliert, nachvollziehbar und mit planbaren Betriebskosten.

KI-Rollout Roadmap (Phase 1–6)

Phase 1 – Pilot & Scope (1–2 Wochen)

- Ziel: Klarer Use Case, sauberes Pilot-Set. - Aktivitäten: Stakeholder-Workshop, Dokumentenliste, Rollen/Rechte, Erfolgskriterien. - Deliverables: Pilot-Scope, Datenfreigaben, KPI-Baseline. - KPIs (Baseline): Ø Suchzeit, Erstlösungsquote (ELQ), Nutzerzufriedenheit (CSAT), Nutzungsfrequenz.Phase 2 – Kuratieren & Ingest (1–2 Wochen)

- Ziel: Verlässliche Wissensbasis. - Aktivitäten: Duplikate entfernen, OCR für Scans, Versionierung, Ingest-Job planen. - Deliverables: Kuratiertes Korpus, automatisierter Ingest (täglich/wöchentlich). - KPIs: Abdeckungsgrad der FAQ/Top-Tasks, Ingest-Fehlerquote < 2 %.Phase 3 – Feintuning Retrieval (1–2 Wochen)

- Ziel: Hohe Treffergenauigkeit. - Aktivitäten: Chunking/Overlap justieren, Reranking parametrieren (Top-K, ef), Suchvarianten (Codes, Synonyme). - Deliverables: Tuning-Profil je Abteilung. - KPIs: ELQ +15–30 %, Zeit bis erster brauchbarer Treffer < 5 s, Anteil „keine Treffer“ < 5 %.Phase 4 – Nutzer-Rollout & Enablement (2 Wochen)

- Ziel: Akzeptanz & Routine. - Aktivitäten: Schulungen/Guides, Sprechstunden, Feedback-Loop (2-wöchig), Upload-Workflow (rollenbasiert). - Deliverables: How-to, Quick-Cards, Feedback-Board. - KPIs: CSAT ≥ 4/5, aktive Nutzerquote > 60 % der Zielgruppe, Support-Tickets zu „Wo finde ich…?“ −30 %.Phase 5 – Skalierung in weitere Bereiche (laufend, in Wellen à 2–4 Wochen)

- Ziel: Mehr Wert pro Team. - Aktivitäten: Vertrieb/Technik/Service nacheinander onboarden; Collections/ACLs je Bereich; Mehrsprachigkeit. - Deliverables: Abteilungs-Collections, Rechte-Matrix, Rollout-Plan. - KPIs: ELQ je Bereich ≥ 70–80 %, Time-to-Answer < 10 s, Suchzeit −40–60 % ggü. vorher.Phase 6 – Erweiterungen & Betrieb (kontinuierlich, 2–4-wöchige Zyklen)

- Ziel: Nachhaltig verbessern. - Aktivitäten: Formulierte Antworten (LLM), optionale externe Quellen (whitelist & DSGVO-Check), SSO, Monitoring, Retention. - Deliverables: Release-Changelog, KPI-Dashboard, Governance-Leitfaden. - KPIs: Stabilität (99,9 %), Ingest-Latenz < 15 min, Anteil Antworten „mit Quelle“ > 95 %, NPS/CSAT steigend.

Ein erstes Fazit

Mit einem leichten Stack (Web-Frontend + FastAPI + Qdrant) lässt sich ein interner KI-Assistent in kurzer Zeit produktionsnah umsetzen – sicher, DSGVO-konform und fachlich belastbar. Anders als bei klassischer Software empfiehlt sich ein schrittweises Rollout: erst ein kleiner Pilot mit klar umrissenem Use Case, dann iterativ skalieren, sobald Qualität und Nutzen belegt sind. Erfolgsentscheidend ist die frühe Einbindung der Mitarbeitenden – die späteren Nutzer:innen testen reale Fragen, geben Feedback und helfen, Inhalte zu kuratieren. So steigt die Akzeptanz, und Bedenken gegenüber KI werden proaktiv adressiert, bevor die Lösung breit in den Betrieb geht. Aber damit muss die Entwicklung nicht enden....

Ihr nächster Schritt?

Wenn Sie vor ähnlichen Herausforderungen stehen, beraten wir Sie gerne – persönlich, kompetent und auf Augenhöhe. Wir entwickeln RAG-Lösungen End-to-End – beraten, implementieren, kuratieren Inhalte und übernehmen den Rollout. Ob erste Einschätzung oder konkrete Umsetzungsidee: Wir sind nicht weiter entfernt als Ihr Telefon.